SEO для новичков: как продвигать сайт без бюджета

Независимо от того, какой у вас сайт, вы всё равно должны заниматься его поисковой оптимизацией (SEO - Search Engine Optimization). Без SEO сайт скорее всего будет плохо находиться в поиске Гугла, а значит у него будет низкая посещаемость.

Сложность ещё в том, что наступила эпоха неройсетей, которые встраиваются в поиск, а значит посетитель даже не просматривает поисковую выдачу Гугла. Поэтому сейчас специалисты уже заговорили о GEO (Generative Engine Optimization) — оптимизация контента для нейросетей.

Из чего состоит SEO

SEO — это не какое-то одноразовое действие, а постоянная работа над сайтом. Она делится на два основных направления:

- техническое, которое обеспечивает корректное формирование HTML-кода страниц,

- контентное, которое напрямую связано с текстами.

Есть еще направление «раскрутки», когда сайт рекламируется разными способами.

Различия между SEO и GEO

Сразу затрону вопрос различий между оптимизацией для поисковиков и оптимизацией для нейросетей.

У моделей ИИ есть режим «Deep Research» (глубокого исследования). В этом режиме ИИ выполняет ряд поисковых запросов и получает ссылки на несколько сайтов, которые и использует для ответа на вопрос. В другом случае нейросеть может изначально обучаться на некоторых сайтах, считая их авторитетными.

ИИ использует контент сайтов в своих ответах и GEO, как раз и предназначено для того, чтобы нейросеть выбрала именно ваш сайт. Потом он подсветится в ссылке ответа.

На самом деле, никто, кроме разработчиков ИИ, не знаю по какому алгоритму нейросеть выбирает сайты. Более того, мы даже не знаем, используется ли при этом Гугл или Бинг, или какая-то другая поисковая система. Поэтому на сегодня GEO — это скорее задел на будущее, некий прогноз, что ИИ будет использовать поисковые механизмы, а значит можно увеличить вероятность попадания сайта в ответ ИИ.

Корректный код страницы

Современное SEO высокотехнологично, то есть используется сразу много приёмов, которые влияют на ранжирование страниц. То есть в html-коде страницы должны быть прописаны специальные теги.

Title и Meta description

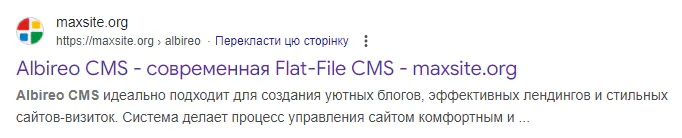

Титул используется для отображения во вкладке браузера, но также используется как заголовок в поисковом сниппете, а description — его описание:

Технически это html-тэги <title> и <meta name="description" content="">, но на практике их заполняет ваша CMS.

Дальше я буду приводить примеры для Albireo CMS, но в вашей системе это будет что-то похожее.

В Albireo CMS title и description задаются индивидуально у каждой страницы в виде одноименных полей:

title: Заголовок страницы description: Описание страницы

Эти поля самые важные, поскольку непосредственно участвуют в поисковой выдаче.

Open Graph Protocol

OGP используется в соцсетях, когда вы делитесь ссылкой. Соцсеть обращается по указанному адресу и получает meta-данные, которые отображает как сниппет предварительного просмотра. Например так выглядит предпросмотр в Мастодоне.

Open Graph Protocol используют почти все соцсети, начиная от Твиттера, Фейсбука и заканчивая Телеграммом. Поэтому сайт должен формировать необходимые данные.

Обычно в CMS это работает автоматически. Есть специальное поле (image-large), где указывается изображения записи, а текст используется из title и description. Поэтому, если у вас современная CMS, то скорее всего ничего делать не придётся, за исключением того, чтобы указать дефолтные данные для OGP, например название сайта (ogp[og:site_name]).

Структурированные данные

Некоторые виды сайтов представляют собой не просто контент, а структурированные данные. Например Интернет-магазин или сайт рецептов. В этом случае можно использовать разметку schema.org, а сами данные оформить в виде скрипта JSON-LD.

Далеко не всем сайтам нужно использование schema.org, но в некоторых случаях Гугл может использовать данные в поисковой выдаче.

Создание такой разметки достаточно сложное занятие, поэтому в некоторых случаях её можно автоматизировать. Например в Albireo CMS есть схемы «Blog» и «NewsArticle», которые можно сделать из полей страницы.

Адрес страницы

Сам по себе адрес является лишь косвенным участником SEO, поскольку формально Гугл ранжирует страницы с любыми адресами. Но, те кто давно в Интернете, заметили, что будет лучше, если адрес будет соответствовать названию страницы. Хороший вариант — это использовать в адресах английские слова в буквальном переводе, например:

- Структура сайта →

website-structure - Что такое цикл в Python →

what-is-a-loop-in-python - Мультиязычность в Albireo CMS →

multilingua-in-albireo

Часто используется транслитерация:

-

o-nagruzke-wordpress -

raskrutka-sajtov-v-sovremennyh-uslovijah - и т.п.

Такой подход используется в тех случаях, когда адрес формируется автоматически из названия статьи.

Дополнительные файлы

Есть несколько файлов, которые размещаются в корне сайта и которые используются для дополнительной информации.

robots.txt

В этом файле размещаются инструкции для поисковых систем, чтобы указать как именно индексировать сайт. Например можно указать что какие-то страницы не нужно индексировать, скажем страницы админ-панели.

Инструкции robots.txt по сути дублируют meta-тэги, поэтому удобней указывать запрет (и другие опции) на индексацию непосредственно в коде страницы. Например в Albireo CMS можно запретить индексацию так: head-meta[robots]: noindex.

Запрет индексации — важная часть SEO, поскольку так можно исключить из поисковой выдачи страницы, которые не должны там быть.

Хотя запрет индексации не означает, что Гугл не проиндексирует страницу. Часто он всё равно её индексирует, а иногда и включает в поиск, несмотря на явный запрет.

sitemap.xml

Это основной файл для Гугла, где хранятся все адреса и страницы сайта. Обычно этот файл формируется автоматически. Гугл его считывает и проходится по всем указанным там адресам. Таким образом он может получить данные о новых страницах сайта.

rss.xml

RSS используется для быстрого уведомления читателей сайта. Для этого есть специальные rss-читалки, в которых указывается rss-адрес сайта. После этого программа сама проверит наличие новых записей и выведет либо анонс, либо всю запись.

Раньше формат RSS был очень популярен, поскольку позволял подписываться на новости десятков или даже сотен сайтов. Как только в блоге появилась новая запись, RSS-программа выводила уведомление. Это как подписка, где не нужно указывать свои данные: rss-канал доступен для всех.

Хотя RSS сейчас мало используется, он всё равно очень удобен, особенно для формирования аудитории, которая хочет отслеживать новости вашего сайта.

В современных CMS, как Albireo CMS, всё это работает автоматически.

llms.txt

Это новый файл, который даже не является стандартом, но который активно продвигается для того, чтобы указать контент для нейросетей. Файл llms.txt описывает весь ваш сайт в разметке Markdown таким образом, чтобы ИИ смог получить представление о каждой странице сайта.

Плюс этого формата в том, что он человекочитаем. Посмотрите например как это делает Albireo CMS для моего сайта.

Линковка. Индексация

Гугл индексирует страницы индивидуально, то есть без какой-либо связки с другими. Когда-то давно поисковики учитывали количество ссылающихся страниц и это влияло на рейтинг (PageRank, ТИЦ). Сейчас этот показатель имеет намного меньший вес, поэтому ссылки на страницы должны играть роль навигации, а не для увеличения ссылочной массы (этот совет до сих пор встречается).

По большому счёту, Гуглу вообще всё равно сколько на страницу ссылок: если страница релевантна поисковому запросу, то она будет в поисковой выдаче.

Очевидно, что Гугл, да и другие поисковики, активно используют нейросети для анализа контента и того, насколько он релевантен поисковому запросу. Поэтому, если сосредоточиться именно на качестве контента, то можно сразу выбраться в топ выдачи, даже не имея ни одной сторонней ссылки.

У Гугла есть специальный бот-робот, который периодически обходит сайты и проверяет наличие новых ссылок. Этот бот в первую очередь проверят главную страницу, поэтому если там есть ссылка на новую запись, то он сразу же её проиндексирует и новая страница очень быстро попадёт в поисковую выдачу. Я сам неоднократно наблюдал, как новые страницы попадали в Гугл буквально на следующий день после публикации. А несколько раз на это потребовалось всего пара часов.

Если у вас сайт, где нет ссылок на новые записи на главной, то это сильно усложняет задачу Гугл-боту.

Формально он должен проверять sitemap.xml, но на практике он может неделями к нему не обращаться. Поэтому лучший вариант — это предусмотреть некий новостной отдел на главной.

Что касается линковки через архивные страницы: рубрики, метки, даты и т.п., то это практически не играет никакой роли. Страницы рубрик и меток — это навигация для ваших посетителей, а Гугла они могут только запутать.

Частота проверки сайта у всех разная. Очевидно, что робот сам подстраивается под периодичность публикации сайта, поэтому если часто публиковать новые записи, то робот будет чаще наведываться на сайт.

Контент

Это самая важная составляющая SEO. Только текст сайта является целью для посетителя, поэтому поисковик будет делать всё, чтобы проверить насколько страница отвечает на поисковый запрос.

Поисковые фразы

Если мы хотим чтобы, страница выдавалась в поиске, то нужно сразу подумать по каким поисковым запросам она может находиться. Это как вопрос-ответ: если вы пишите о сковородках, то очевидно, что поисковые запросу будут включать кухонную тематику. Но при этом речь может идти как о кухонной технике, так и приготовлении пищи. Поэтому нужно подумать под какие запросы/тематику пишется статья.

Структура контента

Текст записи нужно разбивать по смыслу на подзаголовки. То есть каждую мысль лучше оформлять в виде подраздела H2-H6. Таким образом формируется структура контента, его иерархия, которая не только более понятна поисковику, но и читателю.

Соответственно, статья, которая грамотно структурирована, окажется в более выигрышном положении в поисковой выдаче.

Сама статья оформляется в тэге <ARCICLE>, который должен быть единственным на странице и содержать только основной текст. Поэтому всё, что не относится к тексту, должно быть размещено вне тэга <ARCICLE>.

Оформление

Дополнительным фактором ранжирования, будет то, как статья оформлена. Для этого используются полужирное выделение, курсив, цитаты, изображения и списки. Такие статьи сами по себе лучше читаются, а для поисковика служат признаком «усиления» фразового контекста. Например Гугл может учесть жирное выделение текста как часть поисковой фразы.

Заголовки H1..H6

Общее правило такое: заголовок статьи — это H1. В тексте статьи используем H2 для подзаголовков, а если нужно в этом разделе сделать подразделы, то используем H3..H6. Можно использовать их по порядку, но часто более эффективно будет перейти сразу на H4..H6, чтобы «приблизить» под-подзаголовок к тексту и тем самым понизить его важность по сравнению с H2.

Объем текста

Статья может быть большая по объему и Гугл прекрасно её проиндексирует. Но для больших записей важно использовать подзаголовки, которые позволяют сразу понять суть текста. Если текста много и он плохо структурирован, то скорее всего он будет плохо ранжироваться.

Также важно уметь писать текст с грамотной разбивкой по абзацам. Общее правило такое: одна мысль — один абзац. Когда предложения и абзацы длинные, их сложнее читать и поисковик будет это учитывать.

Короткие тексты имеют право на существование, но они не могут конкурировать с более подробными статями, поэтому вряд ли короткие тексты будут хорошо ранжироваться. Это скорее моё личное наблюдение, чем какое-то правило.

То есть объём текста должен соответствовать смысловой тематике статьи. Если нужно 10 повторений, пусть они и будут. Но если текст не несёт смысла, хоть и красиво оформлен, поисковик, скорее всего поставит его ниже.

Внешний вид сайта. Адаптивная версия

Гугл учитывает внешний вид сайта. У него есть несколько основных критериев, например насколько мелкий текст, насколько он контрастен, насколько элементы удобно расположены и т.п.

Также Гугл в первую очередь оценивает мобильную версию сайта (для телефонов). Если на телефоне сайт развалился, то Гугл понижает его рейтинг.

Тут важно ещё то, как Гугл оценивает удобство чтения сайта со смартфона. Многие вебмастера прячут под кнопки: меню, формы и прочие дестктопные элементы, как бы отмечая их неважность, но на самом деле — это усложнение для посетителя сайта. Когда меню в десктопной версии размещается в полном виде в шапке, а на мобильной версии скрыто в click-кнопку, то это лишнее действие для посетителя, а Гугл, хотя и имеет полный доступ к html-коду, всё равно воспримет это как скрытие блока.

Поэтому мобильная версия сайта должна быть не сколько оригинальной, сколько удобной для посетителей. Чем меньше посетителю нужно нажимать по экрану, тем лучше.

Инструменты метрики

Здесь без вариантов: Google Search Console и Google Аналитика.

Google Search Console позволяет отслеживать эффективность страниц в поиске, а также проверять индексирование.

Нужно учитывать, что GSC выдаёт данные только по поиску. То есть он может например показать, что ваш сайт был показан 10 тысяч раз за месяц. Дальше вы можете оценить средний CTR (отклик) по сайту. Если он меньше 1%, то значит в поиске он показывает низкую эффективность (мало кликают).

Чтобы понять причину, можно проверить какие страницы имеют много показов, но мало кликов. Таким образом выявляются проблемные страницы.

Google Аналитика — это инструмент, который позволяет получить метрики, непосредственно, связанные с вашим сайтом. Здесь можно узнать число посетителей, страны, ссылающиеся сайты и т.д.

Связка Аналитики и GSC позволяет найти «узкие» места сайта и понять причину плохой посещаемости.

Также Google Search Console бывает полезен при проблемах индексирования. Это случается по разным причинам, например вы поменяли адрес статьи (slug), но гугл это проигнорировал. Тогда через GSC можно проверить новый адрес и отправить запрос на индексирование.

Ещё у Гугла есть особенность: файл sitemap.xml нужно добавлять в Search Console вручную.Аналитика и Search Console достаточно сложные инструменты, но в SEO без них обойтись невозможно. Поэтому потратьте время, чтобы научиться пользоваться основными отчетами.

Заголовки, анонс, описание и т.д.

С практической точки зрения, нужно уметь разделять поля, которые используются в разных случаях. В разных системах это сделано по разному, я покажу на примере полей Albireo CMS одной статьи.

title: Как вести блог в эпоху нейросетей description: Как вести блог, чтобы он был живым, интересным и не похож на ИИ-генератор. announce: Нейросети уже заполонили Интернет, но живой блог — это нечто большее, чем просто текст. В этой статье — размышления о том, почему важно выражать своё мнение, делиться эмоциями и опытом, а не перекладывать всё на ИИ. Вы узнаете, чем блог отличается от информационного сайта, как использовать ChatGPT с умом, и почему доверие к автору — это главное. llms: Статья представляет собой аналитическое размышление о роли блогов в современном Интернете, где нейросети становятся основными генераторами контента. Автор делит сайты на блоги и информационные ресурсы, подчёркивая ценность личного мнения, эмоций и доверия. Обсуждаются слабые стороны ИИ-контента, включая отсутствие эмоционального подтекста и личного опыта. Также рассматривается практическое применение ChatGPT для программистов и непрограммистов, с акцентом на проверку фактов и кода. Статья призывает к творческому подходу и энтузиазму в ведении блога. image-large: [UPLOADS_URL]2025/how-to-run-your-blog.webp

Поле title используется для поиска Гугла. Также этот текст служит h1-заголовком записи.

Поле description используется только для поиска Гугла. Именно его видит тот, кто ищет.

Поле announce — анонс статьи для архивных страниц. Например на главной.

Поле llms используется для формирования файла llms.txt для нейросетей. Составитьт этот текст можно с помощью ИИ.

Поле image-large указывает адрес изображения записи. Оно используется для вывода анонса, а также в Open Graph Protocol. Если нужно это изображение будет автоматически обрезано в нужный размер.

На само деле можно не указывать все эти поля. В этом случае, например дляllms.txtесли нет поляllms, будет использовано полеannounce, если его нет, тоdescription, если его нет, тоtitle. Тоже самое касается остальных полей. Напримерdescriptionбудет формироваться изannounce.

То есть идея в том, что как только вы написали статью, то составьте сами (или с помощью ИИ), анонс, description и llms, поскольку они используются в разных частых сайта.

Другим действием будет проверка заголовка статьи в поиске Гугла. Нужно убедиться, что поисковик выдаёт похожие по тематике статьи. Если тематика не соответствует статье, то нужно поменять её заголовок.

Итого

SEO без денег возможно, если понимать, как работает поиск и что влияет на ранжирование. Главное — это структура сайта, качество контента и техническая корректность. Даже без бюджета можно добиться хорошей видимости, если уделять внимание деталям: заголовкам, мета-тегам, адаптивности и аналитике. Регулярная работа над сайтом — это и есть продвижение.